python编码规范总结、python编码转换

- 时间:2015年04月02日 15:16:17 来源:魔法猪系统重装大师官网 人气:11113

所有的 Python 脚本文件都应在文件头标上 #-*- coding:utf8 -*- 。设置编辑器,默认保存为 utf8 格式。

编码

Python核心发布中的代码必须始终使用ASCII或Latin-1编码(又名 ISO-8859-1),使用ASCII的文件不必有编码cookie,Latin-1仅当注释或文档字符串涉及作者名字需要Latin-1时才被使用:

另外使用\x转义字符是在字符串中包含非ASCII(non-ASCII)数据的首选方法。

作为PEP 263实现代码的测试套件的部分文件是个例外。

导入

通常应该在单独的行中导入(Imports),例如:

No:import sys, os

Yes:import sys

import os

但是这样也是可以的:

from types import StringType, ListType

Imports 通常被放置在文件的顶部,仅在模块注释和文档字符串之后,在模块的全局变量和常量之前。Imports应该有顺序地成组安放:

1、标准库的导入(Imports )

2、相关的主包(major package)的导入(即,所有的email包在随后导入)

3、特定应用的导入(imports)

你应该在每组导入之间放置一个空行,对于内部包的导入是不推荐使用相对导入的,对所有导入都要使用包的绝对路径。

从一个包含类的模块中导入类时,通常可以写成这样:

from MyClass import MyClass

from foo.bar.YourClass import YourClass

如果这样写导致了本地名字冲突,那么就这样写

import MyClass

import foo.bar.YourClass

即使用"MyClass.MyClass"和"foo.bar.YourClass.YourClass"

【所谓unicode】

unicode是一种类似于符号集的抽象编码,它只规定了符号的二进制代码,却没有规定这个二进制代码应该如何存储。也就是它只是一种内部表示,不能直接保存。所以存储时需要规定一种存储形式,比如utf-8和utf-16等。理论上unicode是一种能够容纳全世界所有语言文字的编码方案。(其他编码格式不再多说)

【所谓GB码】

GB就是“国标”的意思,即:中华人民共和国国家标准。GB码是面向汉字的编码,包括GB2312(GB2312-80),GBK,GB18030,表示范围从小到大递增,而且基本是向下兼容的。此外经常遇到一种叫做CP936的编码,实际上可以大概看做是GBK。

【判断编码】

1、使用isinstance(s, str)来判断一个字符串是否为一般字符串(str为ascii类型的字符串,utf-8、utf-16、GB2312、GBK等都是ascii类型的字符串);

使用isinstance(s, unicode)来判断一个字符串是否为unicode编码形式的字符串(unicode编码的字符串才是unicode类型的字符串)。

2、使用type()或者.__class__

在编码正确的情况下:

例如:stra = "中", 则使用type(stra)的结果是

例如:strb = u"中", 则使用type(strb)的结果是

[python] view plaincopy

tmp_str = 'tmp_str'

print tmp_str.__class__ #

print type(tmp_str) #

print type(tmp_str).__name__ #str

tmp_str = u'tmp_str'

print tmp_str.__class__ #

print type(tmp_str) #

print type(tmp_str).__name__ #unicode

3、最好的办法是使用chardet判断,特别是在web相关的操作中,例如抓取html页面内容时,页面的charset标签只是标示编码,有时候不对,而且页面内容中一些中文可能超出了标示编码的范围,此时用charset检测最为方便准确。

(1)安装办法:下载chardet后,将解压得到的chardet文件夹放在python安装目录的\Lib\site-packages目录下,在程序中使用import chardet即可。

(2)使用办法1:检测全部内容判断编码

[python] view plaincopy

import urllib2

import chardet

res = urllib2.urlopen('http://www.csdn.net/')

res_cont = res.read()

res.close()

print chardet.detect(res_cont) #{'confidence': 0.99, 'encoding': 'utf-8'}

detect函数返回值为一个包含2个键值对的字典,第一个是检测置信度,第二个就是检测到的编码形式。

(3)使用办法2:检测部分内容判断编码,提高速度

[python] view plaincopy

import urllib2

from chardet.universaldetector import UniversalDetector

res = urllib2.urlopen('http://www.csdn.net')

detector = UniversalDetector()

for line in res.readlines():

#detect untill reach threshold

detector.feed(line)

if detector.done:

break

detector.close()

res.close()

print detector.result

#{'confidence': 0.99, 'encoding': 'utf-8'}

【转换编码】

1、从具体的编码(ISO-8859-1[ASCII码],utf-8,utf-16,GBK,GB2312等)转换为unicode,直接使用unicode(s, charset)或者s.decode(charset),其中charset为s的编码(注意unicode在使用decode()时会出错);

[python] view plaincopy

#将任意字符串转换为unicode

def to_unicode(s, encoding):

if isinstance(s, unicode):

return s

else:

return unicode(s, encoding)

注意:这里在decode()的时候,如果遇到非法字符(比如不标准的全角空格\xa3\xa0,或者\xa4\x57,真正的全角空格是\xa1\xa1),就会报错。

解决办法:采用'ignore'模式,即:stra.decode('...', 'ignore').encode('utf-8')。

解释:decode的函数原型是decode([encoding],[errors='strict']),可以用第二个参数控制错误处理的策略。

默认的参数就是strict,代表遇到非法字符时抛出异常;如果设置为ignore,则会忽略非法字符;如果设置为replace,则会用?取代非法字符;如果设置为xmlcharrefreplace,则使用XML的字符引用。

2、从unicode转换为具体的编码,也是直接用s.encode(charset),其中s为unicode编码,charset为具体的编码(注意非unicode在使用encode()时会出错);

3、自然地,从一种具体编码转换为另一种具体编码,就可以先decode成unicode再encode成最终编码了。

【python命令行编码(系统编码)】

用python自带的locale模块来检测命令行的默认编码(也就是系统的编码)和设置命令行编码:

[python] view plaincopy

import locale

#get coding type

print locale.getdefaultlocale() #('zh_CN', 'cp936')

#set coding type

locale.setlocale(locale.LC_ALL, locale='zh_CN.GB2312')

print locale.getlocale() #('zh_CN', 'gb2312')

表明当前系统的内部编码是cp936,近似于GBK。实际上中文XP和WIN7的系统内部编码都是cp936(GBK)。

【python代码中的编码】

1、python代码中的字符串在未被指定编码的情况下,默认编码与代码文件本身的编码一致。举个例子:str = '中文'这个字符串,如果是在utf8编码的代码文件中,该字符串就是utf8编码;如果是在gb2312的文件中,该字符串就是gb2312编码。那么代码文件本身的编码怎么知道呢?

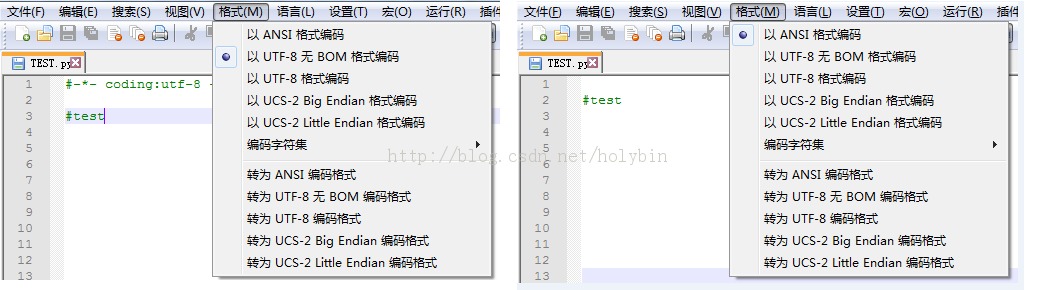

(1)自己指定代码文件的编码:在代码文件的头部加上“#-*- coding:utf-8 -*-”来声明该代码文件为utf-8编码。此时未被指定编码的字符串的编码都变成了utf-8。

(2)在没有指定代码文件的编码时,创建代码文件时使用的是python默认采用的编码(一般来说是ascii码,在windows中实际保存为cp936(GBK)编码)。通过sys.getdefaultencoding()和sys.setdefaultencoding('...')来获取和设置该默认编码。

[python] view plaincopy

import sys

reload(sys)

print sys.getdefaultencoding() #ascii

sys.setdefaultencoding('utf-8')

print sys.getdefaultencoding() #utf-8

结合(1)和(2)做个试验:指定代码文件编码为utf-8时,用notepad++打开显示的是utf-8无DOM编码;未指定代码文件编码时,用notepad++打开显示的是ANSI编码(压缩编码,默认的保存编码形式)。

(3)如何永久地将python默认采用的编码设置为utf-8呢?有2种方法:

第一个方法<不推荐>:编辑site.py,修改setencoding()函数,强制设置为 utf-8;

第二个方法<推荐>:增加一个名为 sitecustomize.py的文件,存放在安装目录下的\Lib\site-packages目录下

sitecustomize.py是在site.py被import执行的,因为 sys.setdefaultencoding()是在site.py的结尾处被删除的,所以可以在 sitecustomize.py使用 sys.setdefaultencoding()。

2、python代码中的字符串如果被指定了编码,举个例子:str = u'中文',该字符串的编码被指定为unicode(即python的内部编码)。

(1)这里有个误区需要注意!假如在py文件中有如下代码:

[python] view plaincopy

stra = u"中"

print stra.encode("gbk")

按上面说的stra是unicode形式,直接encode称gbk编码应该没问题啊?但是实际执行时会报错“UnicodeEncodeError: 'gbk' codec can't encode character u'\xd6' in position 0: illegal multibyte sequence”。

原因在于:python解释器在导入python代码文件并执行时,会先查看文件头有没有编码声明(例如#coding:gbk等)。如果发现声明,会将文件中的字符串都先解释成unicode的形式(这里先用默认编码gbk(cp936)将stra解码成unicode编码'd6d0'后保存),之后执行stra.encode('gbk')时,由于stra已经是unicode编码且'd6d0'在gbk的编码范围内,所以编码不会出现错误;如果文件头没有编码声明,则不会进行上述过程中的解码操作(这里就直接使用stra的unicode编码'd6'),之后执行stra.encode('gbk')时,由于'd6'不在gbk的编码范围所以报错。

(2)为避免这种类型的错误,最好在代码文件头上声明编码,或者麻烦点每次使用setdefaultencoding()。

(3)总的来说就是unicode是python解释器的内码,所有代码文件在导入并执行时,python解释器会先将字符串使用你指定的编码形式解码成unicode,然后再进行各种操作。所以不管是对字符串的操作,还是正则表达式,还是读写文件等等最好都通过unicode来进行。

【python中其他编码】

文件系统的编码:sys.getfilesystemencoding()

终端的输入编码:sys.stdin.encoding

终端的输出编码:sys.stdout.encoding

python 编码转换

主要介绍了python的编码机制,unicode, utf-8, utf-16, GBK, GB2312,ISO-8859-1 等编码之间的转换。

常见的编码转换分为以下几种情况:

自动识别 字符串编码

可以使用 chardet 模块自动识别 字符创编码

chardet 使用方法

unicode 转换为其它编码(GBK, GB2312等)

例如:a为unicode编码 要转为gb2312。a.encode('gb2312')

# -*- coding=gb2312 -*-a = u"中文"a_gb2312 = a.encode('gb2312')print a_gb2312

GBK 与 GB2312的区别

GB 码,全称是GB2312-80《信息交换用汉字编码字符集基本集》,1980年发布,是中文信息处理的国家标准,在大陆及海外使用简体中文的地区(如新加坡等)是强制使用的唯一中文编码。P- Windows3.2和苹果OS就是以GB2312为基本汉字编码, Windows 95/98则以GBK为基本汉字编码、但兼容支持GB2312。GB码共收录6763个简体汉字、682个符号,其中汉字部分:一级字3755,以拼音排序,二级字3008,以偏旁排序。该标准的制定和应用为规范、推动中文信息化进程起了很大作用。

GBK编码是中国大陆制订的、等同于UCS的新的中文编码扩展国家标准。GBK工作小组于1995年10月,同年12月完成GBK规范。该编码标准兼容GB2312,共收录汉字21003个、符号883个,并提供1894个造字码位,简、繁体字融于一库。

GBK 包括 GB2312的所有编码,有些字GB2312没有,需要用GBK来编码。

转: gbk, gb2312,big5,unicode,utf-8,utf-16的区别

其它编码(utf-8,GBK)转换为unicode

例如:a为gb2312编码,要转为unicode. unicode(a, 'gb2312')或a.decode('gb2312')

# -*- coding=gb2312 -*-a = u"中文"a_gb2312 = a.encode('gb2312')print a_gb2312

a_unicode = a_gb2312.decode('gb2312')assert(a_unicode == a)a_utf_8 = a_unicode.encode('utf-8')print a_utf_8

非unicode编码之间的转换

编码1(GBK,GB2312) 转换为 编码2(utf-8,utf-16,ISO-8859-1)

可以先转为unicode再转为编码2

如gb2312转utf-8

# -*- coding=gb2312 -*-a = u"中文"a_gb2312 = a.encode('gb2312')print a_gb2312 a_unicode = a_gb2312.decode('gb2312')assert(a_unicode == a)a_utf_8 = a_unicode.encode('utf-8')print a_utf_8

判断字符串的编码

isinstance(s, str) 用来判断是否为一般字符串

isinstance(s, unicode) 用来判断是否为unicode

如果一个字符串已经是unicode了,再执行unicode转换有时会出错(并不都出错)

下面代码为将任意字符串转换为unicode

def u(s, encoding): if isinstance(s, unicode): return s else: return unicode(s, encoding)

Unicode 与其它编码之间的区别

为什么不所有的文件都使用unicode,还要用GBK,utf-8等编码呢?

unicode可以称为抽象编码,也就是它只是一种内部表示,一般不能直接保存。

保存到磁盘上时,需要把它转换为对应的编码,如utf-8和utf-16。

其它方法

除上以上的编码方法,在读写文件时还可以使用codecs的open方法在读写时进行转换。

命令行默认编码检测和设置

可以用python自带的模块locale来检测命令行默认编码和设置命令行编码。

import locale #get locale.getdefaultlocale()#('zh_CN', 'cp936') #setlocale.setlocale(...)

汉字转Unicode编码

pd_name = pd_name.decode('utf-8')

print pd_name

nname = ""

for c in pd_name:

c = "%%u%04X" % ord(c);

nname += c